取消

知乎崩了!3 亿人刷出空白页,三大技术漏洞戳中互联网平台命门

——KEEP SMILE ~ KEEP ADVANCING——

“早八赶论文查资料,点进知乎全是空白页!”10月17日早高峰,北京大学生小李的吐槽迅速发酵,#知乎崩了#话题10分钟内冲上微博热搜第一,相关讨论量超3亿次。从网页端加载失败到移动端反复登出,这场覆盖全国的服务瘫痪,不仅暴露了头部知识平台的运维短板,更揭开了互联网巨头普遍存在的数字化防线漏洞。

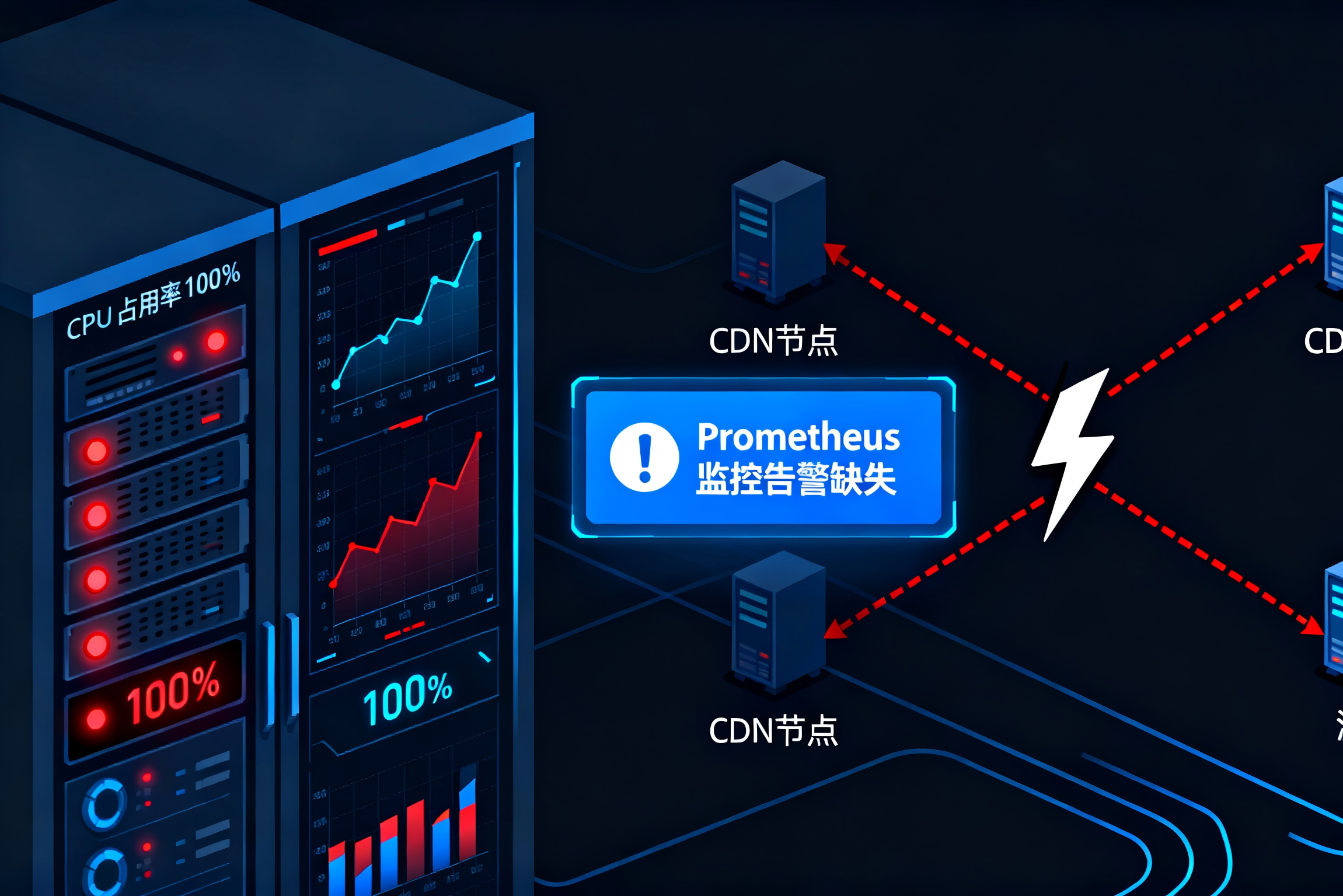

故障现场呈现鲜明的“分层瘫痪”特征。北方用户最早反馈异常,9时许华北地区全面沦陷;南方用户则经历“缓冲式崩溃”,首页缓存内容能显示却无法加载新回答。职场人王女士的经历颇具代表性:“刚刷到一半的职场干货突然卡住,退出重登直接显示匿名,付费会员的专栏还提示‘权限失效’。”技术监测数据显示,故障峰值时全国超62%用户遭遇504网关超时错误,核心症结指向CDN与源站的通信链路中断。

深挖故障根源,三大技术盲区浮出水面。首当其冲的是CDN节点防线失守,知乎采用的边缘节点集群因超时阈值设置过短(仅3秒),当源站因早高峰算力波动延迟4秒响应时,节点直接返回错误。更关键的是数据采集监控缺位,运维团队部署的Prometheus监控系统未覆盖边缘节点的通信延迟指标,直到故障发生40分钟后才通过用户投诉发现问题。

源站服务器的“算力雪崩”则加剧了危机。早高峰9时-9时15分,知乎问答检索请求量同比激增230%,超出服务器集群设计上限。此时本应启动的动态扩容机制,因自动识别模块误判“流量异常为攻击”而失效,导致CPU利用率瞬间飙升至100%,内存溢出引发连锁崩溃。容灾体系的缺位更让局面雪上加霜,备用机房因3个月未同步核心数据,切换时触发数据冲突,彻底丧失应急能力。

用户的恐慌与自救形成鲜明对比。学生群体扎堆百度“知乎崩了怎么查资料”,职场人转向豆瓣小组“替代知乎的摸鱼平台”,付费会员则集中涌入客服通道维权。对此,技术专家给出“三步走自救指南”:先通过DownDetector等平台确认是否为大范围故障;再清理APP缓存并切换Wi-Fi/5G网络,规避本地节点异常;若涉及付费权益,保留订单截图并通过12315平台反馈,可依据《消费者权益保护法》主张补偿。

这场故障并非个例,近期互联网平台“宕机潮”频发。10月13日小红书因阿里云节点故障陷入瘫痪,大量“种草”笔记无法加载;3月X平台遭僵尸网络攻击,全球超4万名用户无法访问。这些案例共同指向一个痛点:数字化扩张中,平台往往重流量争夺轻技术基建,混沌工程演练不足、容灾数据不同步等问题已成行业通病。

截至中午12时,知乎通过临时切流至备用CDN节点恢复服务,并发布致歉声明:付费会员将获3天时长补偿,故障期间未保存的回答可通过后台数据恢复。但信任重建仍需长效机制:架构层面需升级分布式系统,实现服务模块独立容错;运维端要完善全链路数据采集,将边缘节点延迟、服务器负载等指标纳入智能预警;沟通上则需建立故障实时播报通道,避免谣言滋生。

当知识平台成为数字基础设施,稳定性便不再是技术问题,而是民生关切。知乎崩了的背后,是所有互联网企业必须正视的命题:在追逐流量神话前,先筑牢数字化时代的安全防线。

物联网,让世界更精彩;

斯迈尔,让物联网更智能!

浏览器自带分享功能也很好用哦~

浏览器自带分享功能也很好用哦~